Einleitung

Grafikprozessoren (GPUs) und zentrale Prozessoren (CPUs) sind heute essenzielle Bestandteile aller Computersysteme, wobei jede Einheit auf eine bestimmte Art von Aufgaben spezialisiert ist. CPUs wurden entwickelt, um eine Vielzahl komplexer logischer Operationen und Abläufe auszuführen, wodurch sie als das „Gehirn“ des Computers fungieren. Sie steuern Betriebssysteme, Prozesse und die allgemeine Nutzung eines Computers mit höchster Geschwindigkeit. Eine GPU hingegen kann viele Aufgaben gleichzeitig verarbeiten und nutzt dazu parallele Verarbeitung, was sie ideal für grafikintensive Anwendungen und KI-Berechnungen macht, die eine gleichzeitige Verarbeitung zahlreicher Berechnungen erfordern. Dieser Artikel beleuchtet die strukturellen Unterschiede, Leistungsmerkmale und Anwendungsszenarien von GPUs und CPUs und zeigt, wie ihre kombinierten Stärken den technologischen Fortschritt antreiben.

Architektonische Unterschiede

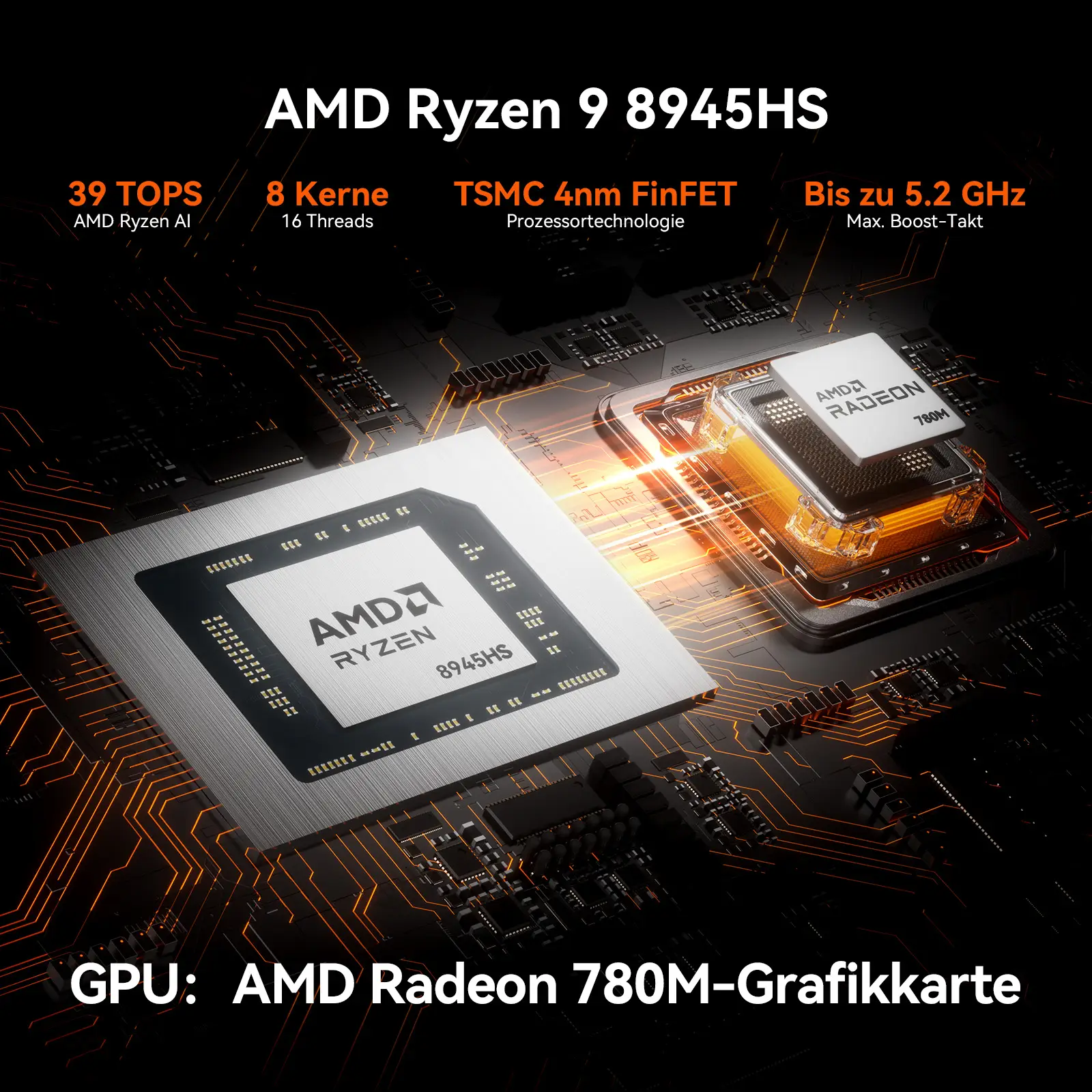

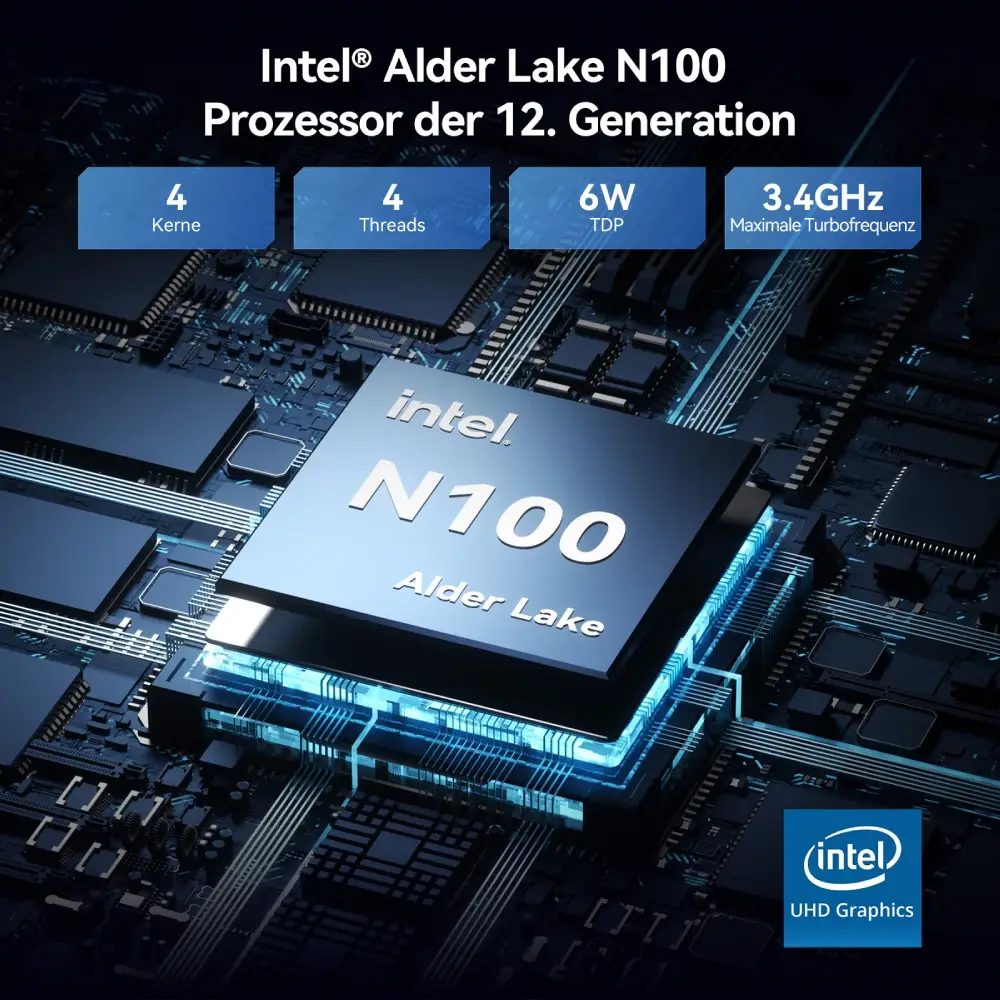

Der grundlegende architektonische Unterschied zwischen der zentralen Verarbeitungseinheit (CPU) und der Grafikeinheit (GPU) liegt in ihrem jeweiligen Design und ihrer Optimierung. CPUs sind auf niedrige Latenzen und die sequentielle Ausführung von Aufgaben ausgelegt. Sie verfügen in der Regel über 4 bis 32 leistungsstarke Kerne und sind für die Verarbeitung komplexer Anweisungen sowie die sequentielle Ausführung von Aufgaben optimiert. Zudem sind CPUs mit einem mehrstufigen Cache-System (L1, L2, L3) ausgestattet, das eine schnelle Datenverarbeitung ermöglicht und sie ideal für Aufgaben macht, die sofortige sequentielle Verarbeitung erfordern, wie z. B. Betriebssystemfunktionen und allgemeine Rechenaufgaben.

Im Gegensatz dazu sind GPUs auf hohe Durchsatzraten und parallele Verarbeitung ausgelegt. Sie verfügen über Tausende kleiner, aber effizienter Kerne, wie beispielsweise die CUDA-Kerne von NVIDIA, die speziell für die gleichzeitige Ausführung vieler Aufgaben entwickelt wurden. Diese Architektur ermöglicht es GPUs, parallele Aufgaben wie Grafik-Rendering, maschinelles Lernen und wissenschaftliche Simulationen effizient auszuführen. Im Gegensatz zu CPUs verlassen sich GPUs auf einen hochbandbreitigen Speicher und eine begrenzte gemeinsame Cache-Struktur, was ihre Fähigkeit unterstützt, große Datenmengen gleichzeitig zu verarbeiten.

Die Designziele jedes Prozessors bestimmen seine optimale Einsatzmöglichkeit. CPUs sind ideal für Aufgaben, die schnelle Entscheidungen und eine nahtlose Ausführung von Anwendungen erfordern, während GPUs speziell für Aufgaben entwickelt wurden, die von Parallelverarbeitung profitieren, z. B. 3D-Rendering und komplexe Berechnungen in maschinellen Lernalgorithmen.

Diese architektonischen Unterschiede zeigen, wie gut CPUs und GPUs zusammenarbeiten können. Während CPUs für die gesamte Systemsteuerung und komplexe Prozessabläufe verantwortlich sind, übernehmen GPUs spezialisierte Aufgaben, die eine hohe Parallelität erfordern, und tragen so zur Gesamtleistung eines Computersystems bei.

Mit der kontinuierlichen Weiterentwicklung der Technologie wird die enge Zusammenarbeit zwischen CPUs und GPUs immer wichtiger und zeigt, wie technologische Fortschritte die Rechenleistung erheblich verbessern können. Diese Synergie zwischen CPU- und GPU-Ökosystemen wird in Zukunft eine Schlüsselrolle bei der Weiterentwicklung der Computertechnologie spielen.

Funktionale und leistungsbezogene Unterschiede

Die funktionalen und leistungsbezogenen Eigenschaften von CPUs und GPUs unterscheiden sie voneinander und bestimmen ihre spezifischen Rollen in der Computertechnologie. Die Hauptaufgabe einer CPU besteht darin, Aufgaben in kleinere Einheiten zu unterteilen, die von mehreren Kernen verarbeitet werden können, wodurch die Verarbeitungsgeschwindigkeit erhöht und die Reaktionszeit verbessert wird. Mit Taktraten von 3–5 GHz sind CPUs besonders gut für Single-Threaded-Aufgaben geeignet, wie z. B. Programmlogik oder KI-gestützte Entscheidungsfindung. Darüber hinaus ermöglichen hochoptimierte Cache-Systeme einen schnellen Zugriff auf Daten und machen CPUs ideal für schnelle, sequentielle Verarbeitungsaufgaben.

GPUs hingegen sind für parallele Verarbeitung optimiert und daher besonders nützlich für datenintensive Aufgaben. Dank ihrer großen Anzahl an Kernen können GPUs Tausende von Threads gleichzeitig verarbeiten, was sie ideal für Aufgaben wie Matrixmultiplikation und Bildverarbeitung macht. Beispielsweise kann eine einzelne Hochleistungs-GPU in wissenschaftlichen Simulationen Hunderte von CPU-Kernen übertreffen und so ihre Effizienz bei parallelen Aufgaben demonstrieren.

In Bezug auf Energieverbrauch und Effizienz haben GPUs bei Aufgaben mit hoher Rechendichte oft einen Vorteil gegenüber CPUs. Ihre parallele Architektur reduziert redundante Berechnungen, wodurch sie weniger Energie verbrauchen als CPU-Cluster, die dieselben Aufgaben ausführen. Daher sind GPUs besonders effizient für energieintensive Anwendungen wie maschinelles Lernen und wissenschaftliche Simulationen, da sie eine erhebliche Leistungssteigerung bei geringerem Energieverbrauch ermöglichen.

Allerdings bieten CPUs im Gegensatz zu GPUs eine größere Flexibilität bei der gleichzeitigen Verwaltung mehrerer Aufgaben. Sie können Ressourcen effizient zuweisen und sind daher besonders geeignet für Multitasking-Prozesse, wie z. B. das gleichzeitige Spielen eines Videospiels und die Verarbeitung von Netzwerkkommunikation.

Die Kombination der Stärken von CPUs und GPUs ermöglicht leistungsstarke Computertechnologien, die die Grundlage für moderne Hochleistungsrechner bilden. Während CPUs sich hervorragend für komplexe und sequentielle Aufgaben eignen, sind GPUs für parallele Verarbeitung optimiert. Diese Synergie verbessert die Gesamtleistung moderner Computersysteme erheblich.

Anwendungsszenarien im Gaming

Im Gaming-Bereich spielen sowohl GPUs als auch CPUs eine entscheidende Rolle. Sie sind für verschiedene Aufgaben verantwortlich, die zusammen ein flüssiges und angenehmes Spielerlebnis ermöglichen.

Für hochauflösendes Rendering und aufwendige visuelle Effekte sind GPUs unverzichtbar. Bei Spielen mit 4K- oder 8K-Auflösung übernimmt die GPU das Rendering komplexer Texturen und fortschrittlicher Beleuchtungstechniken wie Raytracing. Ein Beispiel hierfür ist „Cyberpunk 2077“, bei dem die GPU für realistische Schatten, Beleuchtungseffekte und Umgebungsdetails sorgt. Auch Virtual-Reality-Spiele (VR) erfordern eine leistungsstarke GPU, um eine flüssige Darstellung mit hohen Bildraten und detaillierten Texturen zu gewährleisten. Hier übernimmt die GPU die parallele Verarbeitung mehrerer Datenströme, um ein immersives Erlebnis zu bieten.

Die CPU hingegen ist für komplexe Berechnungen und KI-gesteuerte Entscheidungsprozesse verantwortlich. Während des Spiels steuert die CPU alle Hintergrundprozesse, berechnet physikalische Simulationen und verwaltet die KI von NPCs. In Multiplayer-Online-Spielen (MMOs) spielt die CPU eine entscheidende Rolle bei der Synchronisierung von Spielaktionen über verschiedene Server hinweg.

Eine ausgewogene Verteilung der Arbeitslast zwischen GPU und CPU ist entscheidend für maximale Leistung. Während die GPU für die visuelle Darstellung verantwortlich ist, übernimmt die CPU die Spielmechanik und Entscheidungsprozesse. Entwickler und Spieler müssen daher beide Komponenten berücksichtigen, um ein optimales Spielerlebnis zu gewährleisten.

Zusammenfassend lässt sich sagen, dass die Zusammenarbeit zwischen CPUs und GPUs im Gaming-Bereich ein perfektes Beispiel für ihre komplementären Eigenschaften ist.

Identifizierung und Behebung von Engpässen

Die frühzeitige Erkennung und Behebung von Engpässen ist entscheidend für die Optimierung der Systemleistung und das reibungslose Funktionieren von Spielen und rechenintensiven Anwendungen. Ein Engpass tritt auf, wenn eine Komponente die Gesamtleistung des Systems begrenzt, was häufig zwischen CPU und GPU der Fall ist.

- CPU-Engpass: Dies tritt auf, wenn die CPU die GPU nicht ausreichend mit Daten versorgen kann, sodass die GPU nicht ausgelastet ist. Symptome sind eine niedrige GPU-Auslastung (unter 70 %) und instabile Bildraten. Dies geschieht häufig in Szenarien, in denen die CPU für komplexe KI-Berechnungen oder physikalische Simulationen überlastet ist.

- GPU-Engpass: Das Gegenteil tritt auf, wenn die GPU an ihrer Leistungsgrenze arbeitet, während die CPU nur gering ausgelastet ist. Dies ist typisch bei Spielen mit hohen Auflösungen oder aktivierten erweiterten Grafikeffekten wie Raytracing.

- Erkennung von Engpässen: Spezielle Software kann helfen, Engpässe zu identifizieren. Wenn eine Komponente konstant bei 100 % Auslastung arbeitet, während andere kaum genutzt werden, liegt wahrscheinlich ein Engpass vor.

- Behebung von CPU-Engpässen: Eine Lösung besteht darin, auf eine leistungsstärkere CPU mit mehr Kernen oder höherer Taktrate aufzurüsten. Alternativ kann die CPU-Last durch das Reduzieren von Hintergrundprozessen oder das Optimieren der Software verringert werden.

- Behebung von GPU-Engpässen: Falls ein GPU-Engpass vorliegt, kann eine leistungsstärkere GPU helfen. Alternativ können die Grafikeinstellungen reduziert werden, z. B. durch Senken der Auflösung oder Deaktivieren von leistungshungrigen Funktionen wie Anti-Aliasing.

- Optimierung der Systembalance: Eine ausgewogene Nutzung von CPU und GPU stellt sicher, dass moderne Technologien wie Raytracing und KI-gestütztes Rendering effizient genutzt werden können, ohne dass eine Komponente zum Flaschenhals wird.

Durch das Verständnis der Beziehung zwischen CPU- und GPU-Auslastung sowie die richtige Handhabung von Engpässen kann die Systemleistung erheblich verbessert und das Benutzererlebnis optimiert werden.

Zukünftige Entwicklungen

Die Zukunft der Computertechnologie wird maßgeblich von der Weiterentwicklung von CPUs und GPUs geprägt sein. Beide Komponenten arbeiten zunehmend zusammen und ergänzen sich gegenseitig. Ein bedeutender Trend ist das Aufkommen des heterogenen Rechnens, bei dem CPUs und GPUs gemeinsam genutzt werden, um Aufgaben wie KI-Inferenz und Echtzeit-Rendering effizienter zu bewältigen. Intel und andere Hersteller integrieren bereits KI-Beschleuniger in CPUs, um die Arbeitslast zwischen CPU und GPU intelligenter zu verteilen.

Auch Cloud-Gaming und Edge-Computing verändern das Computing-Ökosystem. Cloudbasierte GPU-Cluster übernehmen zunehmend rechenintensive Aufgaben, während Nutzer auf ihren Geräten lediglich eine Internetverbindung benötigen. Dienste wie NVIDIA GeForce Now und Google Stadia ermöglichen es, Spiele direkt aus der Cloud zu streamen, wodurch leistungsstarke Hardware auf Endgeräten weniger erforderlich wird. Dies könnte langfristig zu einer Demokratisierung des Gamings führen und die Abhängigkeit von teurer Hardware verringern.

Darüber hinaus trägt die wachsende Integration von KI in Gaming und andere Anwendungen zur Entwicklung spezialisierter GPUs bei. Diese GPUs sind darauf ausgelegt, komplexe maschinelle Lernaufgaben auszuführen, um Grafikrendering und Entscheidungsfindungsprozesse in Spielen zu optimieren. Mit der Weiterentwicklung von KI steigt auch die Nachfrage nach GPUs, die für diese anspruchsvollen Berechnungen ausgelegt sind.

Fortschritte in der Halbleitertechnologie, wie kleinere Fertigungsprozesse und höhere Energieeffizienz, ermöglichen nicht nur eine bessere Leistung von CPUs und GPUs, sondern auch einen geringeren Stromverbrauch. Dies ist besonders wichtig für mobile und tragbare Geräte, bei denen die Akkulaufzeit eine entscheidende Rolle spielt.

Zusammenfassend lässt sich sagen, dass die Zukunft von CPUs und GPUs von einer stärkeren Zusammenarbeit, einer verstärkten Nutzung von Cloud-Technologien und KI-Optimierungen geprägt sein wird. Mit der Zeit werden diese Fortschritte zu leistungsfähigeren und effizienteren Computersystemen führen, die in einer Vielzahl von Anwendungen eingesetzt werden können.

Fazit

Die Zusammenarbeit zwischen CPUs und GPUs ist heute unerlässlich für moderne Computersysteme. Beide Komponenten haben ihre eigenen Stärken: CPUs sind hervorragend für komplexe logische und sequentielle Aufgaben geeignet, während GPUs ideal für parallele Berechnungen wie Grafik-Rendering und KI-Verarbeitung sind. Die Weiterentwicklung der Computertechnologie hat die Beziehung zwischen diesen beiden Recheneinheiten gestärkt und ihre Bedeutung in Bereichen wie Gaming, KI und wissenschaftlichem Rechnen erhöht.

Die Zukunft sieht vielversprechend aus, da heterogenes Rechnen, Cloud-Technologien und KI-Optimierungen das Zusammenspiel von CPUs und GPUs weiter verbessern werden. Durch die Nutzung der Stärken beider Komponenten können wir schnellere und effizientere Rechenprozesse ermöglichen.

Letztendlich zeigt die enge Zusammenarbeit zwischen CPU- und GPU-Technologien nicht nur, wie moderne Computersysteme optimiert werden können, sondern auch, wie sie die Grundlage für zukünftige Innovationen bilden. Dies stellt sicher, dass Systeme in der Lage sind, immer komplexere Anwendungen zu bewältigen und den Anforderungen der nächsten Generation gerecht zu werden.